.txt расширение файла

Содержание:

- Robots.txt для Яндекса и Google

- Гипотетическая предыстория

- Устранение неполадок 1TXT-файлов

- Интересные факты о txt

- Из чего состоит robots.txt

- Как проверить файл robots.txt

- Комментарии в robots.txt

- Чем открыть файл в формате TXT

- Чтение и запись в бинарном режиме доступа

- Какими бывают поисковые роботы?

- Резюме файла XMT_TXT

- Проблемы requirements.txt

- Разрешить индексацию robots.txt — Allow

Robots.txt для Яндекса и Google

Веб-мастеры могут управлять поведением ботов-краулеров на сайте с помощью файла robots.txt.

Robots.txt — это текстовый файл для роботов поисковых систем с указаниями по индексированию. В нем написано какие страницы и файлы на сайте нельзя сканировать, что позволяет ботам уменьшить количество запросов к серверу и не тратить время на неинформативные, одинаковые и неважные страницы.

В robots.txt можно открыть или закрыть доступ ко всем файлам или отдельно прописать, какие файлы можно сканировать, а какие нет.

Требования к robots.txt:

- файл называется «robots.txt», название написано только строчными буквами, «Robots.TXT» и другие вариации не поддерживаются;

- располагается только в корневом каталоге — https://site.com/robots.txt, в подкаталоге быть не может;

- на сайте в единственном экземпляре;

- имеет формат .txt;

- весит до 32 КБ;

- в ответ на запрос отдает HTTP-код со статусом 200 ОК;

- каждый префикс URL на отдельной строке;

- содержит только латиницу.

Если домен на кириллице, для robots.txt переведите все кириллические ссылки в Punycode с помощью любого Punycode-конвертера: «сайт.рф» — «xn--80aswg.xn--p1ai».

Robots.txt действует для HTTP, HTTPS и FTP, имеет кодировку UTF-8 или ASCII и направлен только в отношении хоста, протокола и номера порта, где находится.

Его можно добавлять к адресам с субдоменами —

http://web.site.com/robots.txt или нестандартными портами — http://site.com:8181/robots.txt. Если у сайта несколько поддоменов, поместите файл в корневой каталог каждого из них.

Как исключить страницы из индексации с помощью robots.txt

В файле robots.txt можно запретить ботам индексацию некоторого контента.

Яндекс поддерживает

стандарт исключений для роботов (Robots Exclusion Protocol). Веб-мастер может скрыть содержимое от индексирования ботами Яндекса, указав директиву «disallow». Тогда при очередном посещении сайта робот загрузит файл robots.txt, увидит запрет и проигнорирует страницу. Другой вариант убрать страницу из индекса — прописать в HTML-коде мета-тег «noindex» или «none».

Google предупреждает, что robots.txt не предусмотрен для блокировки показа страниц в результатах выдачи. Он позволяет запретить индексирование только некоторых типов контента: медиафайлов, неинформативных изображений, скриптов или стилей. Исключить страницу из выдачи Google можно с помощью пароля на сервере или элементов HTML — «noindex» или атрибута «rel» со значением «nofollow».

Если на этом или другом сайте есть ссылка на страницу, то она может оказаться в индексе, даже если к ней закрыт доступ в файле robots.txt.

Закройте доступ к странице паролем или «nofollow» , если не хотите, чтобы она попала в выдачу Google. Если этого не сделать, ссылка попадет в результаты но будет выглядеть так:

Доступная для пользователей ссылка

Доступная для пользователей ссылка

Такой вид ссылки означает, что страница доступна пользователям, но бот не может составить описание, потому что доступ к ней заблокирован в robots.txt.

Содержимое файла robots.txt — это указания, а не команды. Большинство поисковых ботов, включая Googlebot, воспринимают файл, но некоторые системы могут его проигнорировать.

Если нет доступа к robots.txt

Если вы не имеете доступа к robots.txt и не знаете, доступна ли страница в Google или Яндекс, введите ее URL в строку поиска.

На некоторых сторонних платформах управлять файлом robots.txt нельзя. К примеру, сервис Wix автоматически создает robots.txt для каждого проекта на платформе. Вы сможете посмотреть файл, если добавите в конец домена «/robots.txt».

В файле будут элементы, которые относятся к структуре сайтов на этой платформе, к примеру «noflashhtml» и «backhtml». Они не индексируются и никак не влияют на SEO.

Если нужно удалить из выдачи какие-то из страниц ресурса на Wix, используйте «noindex».

Гипотетическая предыстория

Давайте представим, что вы написали замечательный скрипт,

который спрашивает у пользователя название города и

выводит текущую температуру и общее состояние погоды:

Скрипт получился настолько хорош, что вы хотите поделиться

им со всеми своими друзьями. К сожалению, друзья при попытке

запустить вашу программу получают следующую ошибку:

Кажется, что скинуть только код недостаточно.

Или, допустим, что вы сами через полгода-год попытаетесь

запустить эту же программу. За это время вы успели пару

раз переустановить Python, переустановить ОС, отформатировать свой

магнитный накопитель (используйте SSD — нет, я серьёзно!)

или может быть вообще сменили компьютер.

Почти уверен, что при запуске скрипта вы получите ровно ту же самую ошибку.

Зачастую, когда мы пишем код, мы полагаемся на какие-либо

библиотеки или фреймворки. Это со всех сторон хорошо — это удобно,

уменьшает размер программы во много раз, позволяет не думать о мелких деталях,

а решать свою конкретную задачу, опираясь на высокоуровневые абстракции.

Но, к сожалению, есть «но» — такие библиотеки становятся

частью вашей программы, ваш код становится зависим.

Это значит, что ваш код больше не сможет

работать сам по себе, для его работы должны быть установлены все зависимости.

Если ваша программа небольшая (состоит из пары файлов), то можно

довольно легко просмотреть её глазами, найти там все инструкции ,

отсеять из них импорты из стандартной библиотеки

(вы ведь знаете модули стандартной библиотеки наизусть, да?), и таким образом

восстановить список внешних зависимостей программы, которые устанавливаются

через . Чем крупнее проект, тем сложнее это сделать. Бывают ситуации,

когда по коду вообще нельзя понять, что ему нужна определенная зависимость.

Я хочу сказать, что намного мудрее составлять этот список зависимостей

сразу же и просто поддерживать его в актуальном состоянии по мере развития проекта.

Устранение неполадок 1TXT-файлов

Проблемы при открытии 1TXT-файлов

Unknown Software отсутствует

При двойном щелчке 1TXT-файла может появиться диалоговое окно операционной системы с сообщением о том, что он «Не удается открыть этот тип файла». Когда это происходит, это обычно связано с отсутствием Unknown Software в %%os%%. Поскольку ваша операционная система не знает, что делать с этим файлом, вы не сможете открыть его двойным щелчком мыши.

Совет: Другая программа, связанная с 1TXT, может быть выбрана, чтобы открыть файл, нажав «Показать приложения» и найдя приложение.

Устаревшая версия Unknown Software

Иногда установленная версия Unknown Software не поддерживает файл Enigma Ransomware Affected File. Если у вас нет правильной версии Unknown Software (или любой из других программ, перечисленных выше), вам может потребоваться попробовать загрузить другую версию или одно из других программных приложений, перечисленных выше. Эта проблема в основном возникает, когда файл Enigma Ransomware Affected File был создан более новой версией Unknown Software, чем на компьютере.

Совет: Иногда вы можете получить подсказку о версии 1TXT-файла, который у вас есть, щелкнув правой кнопкой мыши на файле, а затем нажав на «Свойства» (Windows) или «Получить информацию» (Mac OSX).

В конечном счете, большинство трудностей при открытии 1TXT-файлов связаны с установленной неправильной версией Unknown Software.

Хотя на вашем компьютере уже может быть установлено Unknown Software или другое программное обеспечение, связанное с 1TXT, вы по-прежнему можете столкнуться с проблемами при открытии файлов Enigma Ransomware Affected File. Другие ошибки открытия 1TXT могут быть созданы другими системными проблемами внутри %%os%%. К числу этих вопросов относятся:

Интересные факты о txt

Несмотря на то, что TXT сформировала та же компания, что и BTS, мнение фанатов разделилось. В то время, пока одни восхищаются проектом, строят теории и наслаждаются новыми песнями, другие относятся к группе с ревностью и переживают по поводу того, что Big Hit со временем потеряют интерес к своему старому проекту – BTS.

Так как TXT тоже являются частью Big Hit, их прозвали «Братья BTS».

Официальный логотип группы очень похож на модель атома. Поэтому можно сравнить всех участников с электронами, которые движутся вокруг ядра атома.

Многие предполагают, что Big Hit планируют связать историю TXT с астрономией. Ведь новый логотип, который недавно появился в Интернете, изображает два пересекающихся круга, что очень напоминает солнечное затмение.

Из чего состоит robots.txt

Файл должен называться только «robots.txt» строчными буквами и никак иначе. Его размещают в корневом каталоге — https://site.com/robots.txt в единственном экземпляре. В ответ на запрос он должен отдавать HTTP-код со статусом 200 ОК. Вес файла не должен превышать 32 КБ. Это максимум, который будет воспринимать Яндекс, для Google robots может весить до 500 КБ.

Внутри все должно быть на латинице, все русские названия нужно перевести с помощью любого Punycode-конвертера. Каждый префикс URL нужно писать на отдельной строке.

В robots.txt с помощью специальных терминов прописываются директивы (команды или инструкции). Кратко о директивах для поисковых ботах:

«Us-agent:» — основная директива robots.txt

Используется для конкретизации поискового робота, которому будут давать указания. Например, User-agent: Googlebot или User-agent: Yandex.

В файле robots.txt можно обратиться ко всем остальным поисковым системам сразу. Команда в этом случае будет выглядеть так: User-agent: *. Под специальным символом «*» принято понимать «любой текст».

После основной директивы «User-agent:» следуют конкретные команды.

Команда «Disallow:» — запрет индексации в robots.txt

При помощи этой команды поисковому роботу можно запретить индексировать веб-ресурс целиком или какую-то его часть. Все зависит от того, какое расширение у нее будет.

User-agent: Yandex Disallow: /

Такого рода запись в файле robots.txt означает, что поисковому роботу Яндекса вообще не позволено индексировать данный сайт, так как запрещающий знак «/» не сопровождается какими-то уточнениями.

User-agent: Yandex Disallow: /wp-admin

На этот раз уточнения имеются и касаются они системной папки wp-admin в CMS WordPress. То есть индексирующему роботу рекомендовано отказаться от индексации всей этой папки.

Команда «Allow:» — разрешение индексации в robots.txt

Антипод предыдущей директивы. При помощи тех же самых уточняющих элементов, но используя данную команду в файле robots.txt, можно разрешить индексирующему роботу вносить нужные вам элементы сайта в поисковую базу.

User-agent: * Allow: /catalog Disallow: /

Разрешено сканировать все, что начинается с «/catalog», а все остальное запрещено.

На практике «Allow:» используется не так уж и часто. В ней нет надобности, поскольку она применяется автоматически. В robots «разрешено все, что не запрещено». Владельцу сайта достаточно воспользоваться директивой «Disallow:», запретив к индексации какое-то содержимое, а весь остальной контент ресурса воспринимается поисковым роботом как доступный для индексации.

Директива «Sitemap:» — указание на карту сайта

«Sitemap:» указывает индексирующему роботу правильный путь к так Карте сайта — файлам sitemap.xml и sitemap.xml.gz в случае с CMS WordPress.

User-agent: * Sitemap: http://pr-cy.ru/sitemap.xml Sitemap: http://pr-cy.ru/sitemap.xml.gz

Прописывание команды в файле robots.txt поможет поисковому роботу быстрее проиндексировать Карту сайта. Это ускорит процесс попадания страниц ресурса в выдачу.

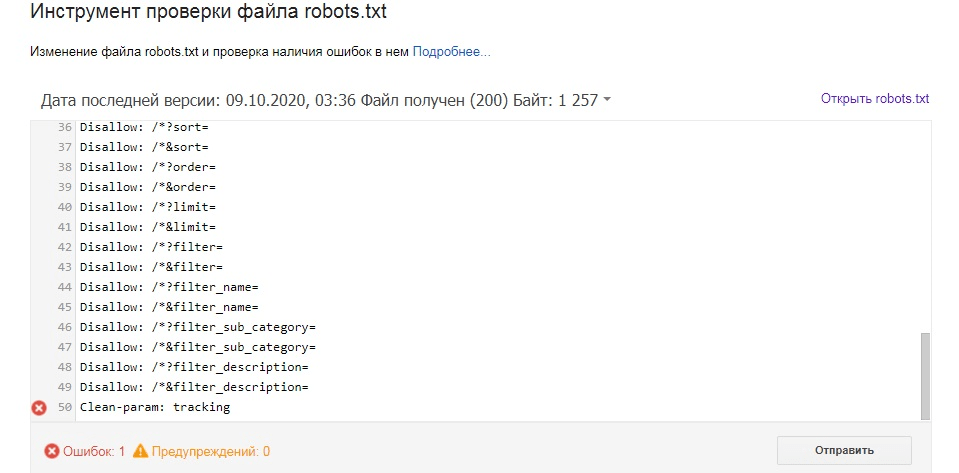

Как проверить файл robots.txt

Иногда ошибки в файле robots.txt могут привести не только к исключению из индексации важных страниц, но и к попаданию всего ресурса в невидимую для поисковиков зону. Для вебмастеров в Google и Яндексе есть сервисы для анализа robots.txt.

В Google

Опция проверки файла robots.txt отсутствует в новом интерфейсе Google Search Console. Теперь можно проверять индексацию страниц по отдельности (Проверка URL) или же отправлять запросы на удаление URL (Индекс — Удаления). Перейти к «Инструменту поверки файлов robots.txt» можно напрямую.

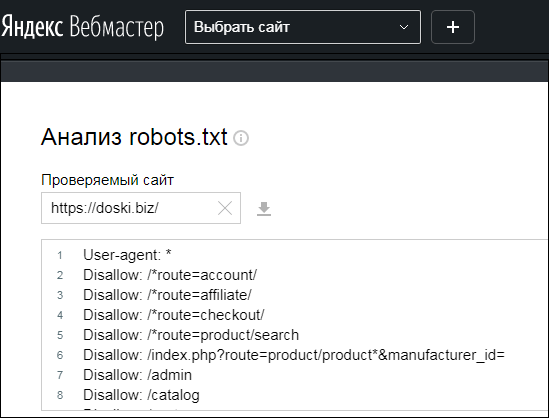

В Яндексе

Инструмент Анализ robots.txt доступен в Яндекс.Вебмастер. Авторизация и подтверждение прав здесь не требуется — можно поверить любой ресурс.

Также в Вебмастере можно проверить код ответа сервера на запрос Яндекс-робота.

Комментарии в robots.txt

Комментарии в файле robots.txt пишутся после знака # и игнорируются поисковыми системами. Как правило, комментарии используются для обозначения причин открытия или закрытия для индексации определенных страниц, чтобы в будущем оптимизатору были понятны причины тех или иных правок в файле.

В данной статье вы уже встречались с комментирование, которое поясняло использование директив. Вот еще один пример:

#Это файл robots.txt. Все что написано в данной строке, роботы не прочтут User-agent: Yandex #Комментарий Disallow: /pink #закрыл от индексации, так как на странице неуникальный контент

Чем открыть файл в формате TXT

Формат TXT является самым распространенным форматом хранения и передачи текстовых данных после Doc. TXT файл может представлять собой форматированный/неформатированный блок текстовой информации, реализованный в виде последовательности строк.

К любому текстовому блоку такой информации могут быть применены инструменты форматирования и установлены: размер и стиль написания шрифта, величина межстрочного интервала, а также другие элементы начертания в зависимости от потребностей пользователя.

В ОС Windows файл TXT носит название “Документ текстовый”. Если TXT файл находится в пакете устанавливаемого ПО, то он будет иметь имя “Readme” (в подавляющем большинстве случаев).

TXT – самый элементарный формат представления текстовых данных, но он положен в основу более специализированных расширений, таких как XML, PHP и CHM.

Текстовый документ TXT может поддерживать редактирование не только на ПК с различными ОС (Windows, Mac, Linux), но и на мобильных устройствах iPhone и iPad в системе Android. Также, электронные книги Txt поддерживаются на мобильных платформах.

Программы для открытия TXT файлов

Тxt программа для большинства пользователей ОС Windows — традиционный “Блокнот” или стандартные средства Microsoft Office (MS Word).

Весьма примечательно, что работа с расширением TXT реализована на большинстве интернет-браузеров (Internet Explorer, Opera и др). Среди других распространенных приложений(для которых предварительно требуется скачать Txt документ), поддерживающих создание/открытие/редактирование файлов, можно выделить:

- Staroffice (ОС Windows);

- Geany (ОС Windows);

- Abiword (ОС Windows);

- Apple textedit (ОС Mac);

- Calibre (ОС Mac);

- Planamesa neooffice (ОС Mac);

- gedit (ОС Linux);

- Kwrite (ОС Linux).

Для отображения текстовой информации на экране iPhone, iPad или других мобильных устройств может быть использована одна из программ Kingsoft office for Android или Officesuite viewer.

.png)

Как конвертировать TXT в другие форматы

Среди конвертируемых форматов и рекомендуемых для программ (а также для конвертации txt онлайн), можно отметить:

- TXT -> ASCII (рекомендуемое ПО – Microsoft windows notepad);

- TXT -> ASC, TXT -> AWW (рекомендуемое ПО – Ability write);

- TXT -> CBR (рекомендуемое ПО – Free online file conversion);

- TXT -> DOC, TXT -> DOCX, TXT -> ODT, TXT -> PDF, TXT -> RTF (рекомендуемое ПО – Abiword);

- TXT -> EPUB, TXT -> SNB (рекомендуемое ПО – Calibre);

- TXT -> LWP (рекомендуемое ПО – Ability write).

Данное ПО поддерживает свою работу на базе ОС Windows.

Почему именно TXT и в чем его достоинства?

Можно сказать, что расширение TXT – один из самых универсальных форматов хранения и передачи текстовой информации. TXT файлы прекрасно адаптированы под самые разнообразные текстовые редакторы, включая внутренние приложения ОС.

- Тип файла:

- Plain Text File

- Категория:

- Текстовые файлы

Стандартный текстовый документ формата TXT (аналогично тхт), содержащий неформатированный текст. Распознается любой программой редактирования или обработки текста. Может также обрабатываться многими другими программами.

Групповые текстовые файлы с названиями, заканчивающимися на «.txt», создаются при помощи Notepad для Windows и TextEdit для Mac OS X при удалении форматирования документа.

Различные устройства, такие как смартфоны или электронные книги Amazon Kindle, также могут распознавать простые текстовые файлы.

MIME-тип: text/plain

Другие похожие форматы и расширения файлов

| .TXN | .TXF | .TXD | .TXA |

| .TXTRPT | .TXW | .TXZ | .TYPEIT4ME |

- https://itswat.ru/format-txt-open/

- https://fileext.info/extension/txt

- https://www.azfiles.ru/extension/txt.html

Чтение и запись в бинарном режиме доступа

Что такое

бинарный режим доступа? Это когда данные из файла считываются один в один без

какой-либо обработки. Обычно это используется для сохранения и считывания

объектов. Давайте предположим, что нужно сохранить в файл вот такой список:

books =

("Евгений Онегин", "Пушкин А.С.", 200),

("Муму", "Тургенев И.С.", 250),

("Мастер и Маргарита", "Булгаков М.А.", 500),

("Мертвые души", "Гоголь Н.В.", 190)

Откроем файл на

запись в бинарном режиме:

file = open("out.bin", "wb")

Далее, для работы

с бинарными данными подключим специальный встроенный модуль pickle:

import pickle

И вызовем него

метод dump:

pickle.dump(books, file)

Все, мы

сохранили этот объект в файл. Теперь прочитаем эти данные. Откроем файл на

чтение в бинарном режиме:

file = open("out.bin", "rb")

и далее вызовем

метод load модуля pickle:

bs = pickle.load(file)

Все, теперь

переменная bs ссылается на

эквивалентный список:

print( bs )

Аналогичным

образом можно записывать и считывать сразу несколько объектов. Например, так:

import pickle

book1 = "Евгений Онегин", "Пушкин А.С.", 200

book2 = "Муму", "Тургенев И.С.", 250

book3 = "Мастер и Маргарита", "Булгаков М.А.", 500

book4 = "Мертвые души", "Гоголь Н.В.", 190

try:

file = open("out.bin", "wb")

try:

pickle.dump(book1, file)

pickle.dump(book2, file)

pickle.dump(book3, file)

pickle.dump(book4, file)

finally:

file.close()

except FileNotFoundError:

print("Невозможно открыть файл")

А, затем,

считывание в том же порядке:

file = open("out.bin", "rb")

b1 = pickle.load(file)

b2 = pickle.load(file)

b3 = pickle.load(file)

b4 = pickle.load(file)

print( b1, b2, b3, b4, sep="\n" )

Вот так в Python выполняется

запись и считывание данных из файла.

Какими бывают поисковые роботы?

Поисковой робот — это специальная программа, которая сканирует страницы ресурса и заносит их в базу данных поисковой системы. В Google и Яндексе есть несколько ботов, которые отвечают за разные типы контента.

Виды роботов Google

- Googlebot: бот для сканирования сайтов для ПК и мобильный устройств

- Googlebot Image: отвечает за показ изображений сайта в разделе «Картинки»

- Googlebot Video: отвечает за сканирование и отображение видео

- Googlebot News: отбирает самые полезные и качественные статьи для раздела «Новости»

- AdSense: оценивает сайт как рекламную платформу с точки зрения релевантности объявлениям

Полный список роботов Google (агентов пользователей) перечислен в официальной Справке.

Виды роботов Яндекс

- YandexBot: основной робот, отвечающий за сканирование страниц ресурсов

- YandexImages: сканирует изображения

- YandexNews: влияет за наполнение раздела Яндекс.Новости.

- MirrorDetector: робот, определяющий зеркала сайтов

- YandexDirect: робот рекламной сети, анализирующий тематику ресурса

Кроме поисковых роботов сайт могут сканировать краулеры аналитических ресурсов, например, Ahrefs или Screaming Frog. Их программное обеспечение работает по тому же принципу, что и поисковик — парсинг URL для занесения в собственную базу.

Боты, от которых сайт следует закрыть:

- вредоносные парсеры (спам-боты, собирающие адреса электронной почты клиентов, вирусы, DoS- и DDoS-атаки и другие);

- боты других компаний, мониторящих информацию с целью дальнейшего использования в своих целях (цены, контент, SEO-методы и т.д.).

Если вы примите решения закрыть сайт от указанных выше роботов, лучше использовать не robots.txt, а файл .htaccess. Второй способ надежнее, так как он ограничивает доступ не в качестве рекомендации, а на уровне сервера.

Команду нужно указывать внизу файла .htaccess. Запрет сканирования для каждого робота должен быть указан в отдельной строке.

Если же все-таки решите использовать robots.txt, укажите в нем всех названия всех в таком формате:

User-agent:

Disallow: /

Таким образом вы ограничите доступ роботов ко всем страницам сайта.

В конце статьи вы найдете со списком роботов, которым вы возможно хотели бы ограничить доступ к своему сайту, чтобы они не собирали информацию о вашем ресурсе. Список не исчерпывающий — вы можете добавить в него других ботов.

Решение блокировать определенного бота и нет рекомендуем принимать исходя из ваших индивидуальных потребностей. Например, если вы пользуетесь каким-то сервисом, конечно же, вам стоит дать его боту возможность сканировать ваш сайт.

Резюме файла XMT_TXT

Расширение файла XMT_TXT включает в себя один основных типов файлов и его можно открыть с помощью Parasolid (разработчик — Siemens PLM Software). В общей сложности с этим форматом связано всего один программное (-ых) обеспечение (-я). Чаще всего они имеют тип формата Parasolid CAD Format.

Большинство файлов XMT_TXT относится к CAD Files.

Просматривать файлы XMT_TXT можно с помощью операционных систем Windows, Mac и Linux. Они обычно находятся на настольных компьютерах (и ряде мобильных устройств) и позволяют просматривать и иногда редактировать эти файлы.

Рейтинг популярности расширения файла XMT_TXT составляет «Низкий», что означает, что эти файлы, как правило, не встречаются в большинстве файловых хранилищ пользователя.

Проблемы requirements.txt

Некоторые пакеты часто меняются, поэтому если вы не указываете конкретные

версии, то в следующий раз при установке вы можете получить совсем другую

среду. Это бывает особенно обидно, когда локально на машине разработчика

всё работает правильно, но при деплое на боевой сервер программа либо работает

иначе, либо вообще отказывается запускаться. Поэтому обязательно фиксируйте

версии пакетов в — это сделает разные окружения хотя бы

примерно похожими.

Почему «хотя бы примерно»? Практика показывает, что зафиксировать версию

пакета недостаточно. Иногда случается, что под одной версией пакета в разное

время может находиться совершенно разный код. PyPI, конечно, не позволит

перезаписать уже опубликованную версию, но, например, ваш приватный

корпоративный индекс пакетов может быть не таким строгим.

Чтобы действительно гарантировать, что вы устанавливаете те пакеты, что и

ожидали, нужно рассчитывать и сверять их контрольные суммы.

может ,

но, к сожалению, на данный момент нет

простого стандартного способа как их туда положить, кроме как вручную (сложно).

В качестве альтернативы опять предлагаю присмотреться к таким проектам, как

(хранит хэши в )

и (хранит хэши в ), где эта

проблема решена хорошо,

и вам не придётся переживать о воспроизводимости ваших сборок.

Если всё-таки хочется добиться такого же эффекта при помощи

, то можно посмотреть на такие проекты как

()

и .

Разрешить индексацию robots.txt — Allow

Allow — это директива разрешающая поисковому роботу обход страниц. Она является противоположностью директиве Disallow. В ней, как и в Disallow возможно использование спецсимволов * и $.

Давайте рассмотрим пример использования директивы Allow:

User-agent: * Disallow: / Allow: /blog

Данные инструкции разрешают обход раздела /blog, при этом весь остальной сайт остается недоступен для индексирования.

Пустой «Disallow: » = «Allow: /». Обе директивы разрешают полный обход сайтаПустой «Allow: » = «Disallow: /». Обе директивы полностью запрещают обход сайта.

Эта информация дана для справки. Широкого практического применения она не получает.